Tecnopolítica

Palantir y la inteligencia artificial militar española: una historia de privatización, racismo y crímenes

Las transformaciones estructurales en el capitalismo global que ha acarreado la inteligencia artificial (IA) se muestran cada vez más como lo que son: la digitalización al servicio del “neoliberalismo militar”, con los Estados desplazando cada vez más recursos públicos hacia el sector privado. No obstante, los Estados que lubrican a base de contratos el vector principal de acumulación de capital contemporáneo se posicionan de manera mucho más ambivalente. Como reza el gobierno español en su estrategia de inteligencia artificial, esta tecnología tiene como objetivo proporcionar el desarrollo de una IA inclusiva, sostenible y centrada en la ciudadanía. En una muestra de solucionismo tecnológico, se presenta como una creación tecnológica que contribuirá al progreso social en el presente y que además nos ayudará a resolver los problemas más acuciantes del mañana, desde “el reto demográfico” a la reindustrialización, pasando por la transición “verde y digital”.

Analizada bajo un ojo crítico, la realidad es mucho menos optimista. Organizaciones procedentes de la sociedad civil o de la comunidad académica, como Algorights, AlgoRace, Tecnopolítica, Xnet, Riders x Derechos, el Movimiento Salvemos la Montaña y otras tantas, llevan varios años señalando las muchas sombras que rodean a este prometido paraíso cibernético. Por ejemplo, el uso que hacen las policías nacionales y autonómicas de la IA para vigilar y castigar la disidencia política y criminalizar migrantes. También el extractivismo de datos sobre el que se levanta la transición sostenible y digital, que tampoco podría existir sin el extractivismo de recursos hídricos, minerales y energéticos.

Otros ejemplos son los algoritmos de toma de decisiones automatizadas empleados de manera creciente en la administración pública con el triple objetivo de ahorrar personal, limitar las ayudas y favorecer la privatización de servicios. Lo mismo ocurre con otros sectores públicos, como la educación o la sanidad, donde la introducción de estas tecnologías se utiliza como un contraproducente remedio frente a la infrafinanciación en medios y personal.

El ejército español, con la colaboración de corporaciones criminales y universidades públicas, está desplegando su particular versión del capitalismo digital consistente en la privatización de infraestructuras, multiplicación de la vigilancia y uso de herramientas militares contra la población civil

No obstante, existe un aspecto más relevante y a la vez menos conocido: la llamada inteligencia artificial militar. Pese al dulcificado discurso en materia de derechos humanos del gobierno, el ejército español, con la inestimable colaboración de corporaciones criminales y universidades públicas, está desplegando su particular versión del capitalismo digital consistente en la privatización de infraestructuras, multiplicación de la vigilancia y uso de herramientas militares contra la población civil. En otras palabras, tras la imagen triunfalista de los gurús tecnológicos sobre la IA, existe una historia de despojo, explotación, devastación ambiental y crímenes de estado.

La estrategia militar del Gobierno español

En este contexto debe entenderse que el pasado mes de noviembre España se sumara, junto a una treintena de países liderados por Estados Unidos, a la “Declaración Política sobre el uso Militar Responsable de la Inteligencia Artificial.” Los países firmantes del documento se comprometían así a mantener el control final humano sobre las decisiones automatizadas; a vigilar que no haya sesgos algorítmicos; a que las armas se ajusten a los fines para los que han sido diseñadas (aplastar al enemigo); a que estas estén programadas de acuerdo a los principios del derecho internacional humanitario; o a que se documenten su desarrollo a fin de que sean auditables y transparentes. Cumpliendo con estos requisitos, cualquier problema social o político relacionado con la IA estaría resuelto. ¿O acaso no tienen los Estado el legítimo derecho a defenderse de ataques terroristas?

Con esta declaración, el Estado español satisface dos objetivos. Por un lado respalda una visión tradicional imperial del derecho internacional donde se regulan los tecnicismos de la guerra sin cuestionar la legitimidad del orden imperial que las promueve. Por el otro, llena una vergonzosa laguna sobre el uso de la IA en materia de defensa y seguridad que, como han señalado numerosas organizaciones sociales y de protección de los derechos digitales, han sido aspectos convenientemente excluidos de la flamante e inservible legislación europea sobre IA (la policía podría usar reconocimiento facial sin aprobación judicial). Lo hace defendiendo retóricamente una visión progresista y responsable, en este caso, mediante “la prohibición de armas autónomas” y la “regulación ajustada al derecho internacional humanitario de los sistemas semiautónomos”, mientras abre la puerta al desarrollo de los peores usos de estas tecnologías.

Los debates sobre la inteligencia artificial ética en el terreno militar no entran en el fondo imperial, colonial o racista de los conflictos, sino que defiende el “legítimo” derecho de los países a defenderse, y atacar, en una aceptación tácita del viejo discurso estadocentrista y colonial-imperial de la guerra justa

De manera similar puede mencionarse la citada estrategia de inteligencia artificial del Gobierno español. El documento, de tan solo diez páginas, traza las líneas estratégicas, políticas y organizacionales del uso de la IA en el ejército. Para ello, reconoce la importancia y potencia disruptiva de la IA militar y su influencia en la futura articulación del campo de batalla entendido este en su sentido amplio e híbrido. Por ejemplo, la necesidad de adaptación de las fuerzas armadas fijando como objetivo su implementación a todos los niveles en el ejército español, desde las misiones estratégicas nacionales, al resto de dimensiones logísticas, preparativas y de investigación.

Para este fin, se dota también de una estructura orgánica reforzando la actual Oficina del Director de Sistemas y Tecnologías de la Información y las Comunicaciones, e introduce figuras ejecutivas propias del mundo corporativo Big Tech, como la del Chief Data Officer. El documento señala una agenda estratégica de implementación que, aunque se plantea como progresiva, anuncia el horizonte de un ejército digitalizado en torno a conceptos como el de nube militar. En palabras del documento, se trata de “potenciar y armonizar todas las áreas de la gestión del dato,” dotándose de una infraestructura de IA militar propia y catalizando la I+D+i en torno al mundo militar.

En este contexto se debe entender que Pablo Casado y el sobrino de Ana Botín se aliaran para lanzar un fondo de 150 millones en defensa e IA. O en el de otra noticia reciente, donde se señalaba que la Ministra de Defensa Margarita Robles estaba inmersa en plenas tareas de reclutamiento buscando la complicidad de las universidades españolas para el desarrollo del incipiente complejo industrial-tecnológica-militar español. Este ha sido el caso del Centro de Inteligencia Artificial del Centro Tecnológico de Desarrollo y Experimentación (CIA-CETEDEX), situado en Jaén.

Sea como fuere, la estrategia del Gobierno español trata de satisfacer las críticas y suspicacias académicas mainstream existentes sobre el uso IA militar en lo que ha venido a configurarse como todo un nuevo campo de la ética y la filosofía moral sobre la guerra. ¿Cuándo, cómo y por qué estaría justificado el uso de armas autónomas y semiautónomas? ¿Cómo, cuándo y por quién debería regularse? Para ello se han propuesto infinidad de soluciones, desde la sujeción de estas armas al derecho humanitario “por código”, a la implementación de protocolos más o menos complejos. Todo ello con la finalidad de crear armas “éticas” que contribuyan a solucionar crisis humanitarias.

Pero los grandes debates de la IA ética aplicada al ámbito militar no entran en el fondo imperial, colonial o racista de los conflictos, sino que defiende el “legítimo” derecho de los países a defenderse, y atacar, en una aceptación tácita del viejo discurso estadocentrista y colonial-imperial de la guerra justa. No se preocupa, por ejemplo, las razones espúrias que llevaron a Estados Unidos a invadir Irak o el actual genocidio en Gaza perpetrado por Israel. Simplemente responden a las ansiedades eurocéntricas y liberales del capitalismo individualista: la necesidad de incluir al “humano” en la decisión, y que el sistema evite sesgos algorítmicos. Al parecer, cualquier duda ética sobre la masacre desde el punto de vista de la IA militar estaría, de esta forma, resuelta.

El rol de Palantir en la inteligencia artificial militar

Para entender qué implicaciones tendrán declaraciones y estrategias de este tipo, cabe señalar que solo un mes antes de la publicación de dichos documentos Newtral revelaba la adjudicación de 16,5 millones por parte del Ministerio de Defensa a la compañía estadounidense Palantir para desarrollar sistemas de análisis y fusión de datos con tecnologías basadas en IA. Dicho de otra manera, una firma estadounidense construirá la infraestructura tecnológica fundamental para alcanzar la interoperabilidad entre diferentes agencias y fuentes de información. No se trata solo de flujo de datos y conexiones entre bases de datos de las diferentes agencias. También es la base sobre la que se edificarán todo tipo de sistemas de seguridad altamente tecnologizados, desde la predicción, la vigilancia o la toma (semi) automatizada de decisiones.

Como se ha visto en multitud de jurisdicciones, este tipo de tecnologías no hace más que reafirmar los prejuicios raciales y clasistas de los cuerpos de seguridad que los usan, ya que establecen predicciones y correlaciones entre las bases de datos existentes. Por ejemplo, indicando que sujetos pueden ser más proclives a cometer actos terroristas, o qué zonas podrían ser más propensas a ser fuente de amenazas contra la seguridad nacional. Sobra decir que lo que es considerado como amenaza, riesgo o terrorismo responde a los criterios fijados por los cuerpos de seguridad. Es decir, sirven como mecanismos de validación científica de actuaciones represoras, permitiendo además la entrada del sector privado en sectores críticos de la seguridad y el bienestar colectivos.

Palantir, una empresa que se al calor de la “Guerra contra el terror” con financiación de la CIA, que proporcionaba tecnología de contrainsurgencia al ejército estadounidense en Irak y ahora a Israel para seguir desplegando el apartheid en Palestina, estará a cargo de la infraestructura tecnológica del Ministerio de Defensa

Ello es incluso más problemático si se tiene en cuenta la historia de Palantir, una empresa o “plataforma de vigilancia" que se fundó en el 2003 al calor de la “Guerra contra el terror”, y con financiación de la CIA, quien trataba de proporcionar tecnología avanzada de contrainsurgencia al ejército estadounidense en Irak. Las herramientas desarrolladas para dicho fin, el de rastrear “terroristas”, fueron después convertidas en armas de vigilancia usadas por cuerpos de policía de todo el mundo, especialmente en Estados Unidos, donde Palantir ha recibido incontables denuncias por el sesgo racista de su armamento digital.

No obstante, su verdadera expansión llegó durante el mandato de Donald Trump, a quien su fundador, el controvertido Peter Thiel, realizó sustanciosas donaciones. De la mano del magnate, Palantir se convirtió en un contratista de primer nivel, proporcionando herramientas para el espionaje de millones de ciudadanos así cómo a los servicios de fronteras, junto a los que ha colaborado activamente en la vigilancia y deportación de migrantes. Cuando Trump prometió levantar un muro tan impenetrable como imposible, Palantir estaba allí, dispuesto a edificar su versión digital: una tecnología de rastreo diseñada para la caza de migrantes “ilegales”.

Pero los problemas no se acaban con su uso en materia de seguridad nacional. Estas tecnologías de espionaje masivo concebidas como excepcionalidad no han tardado en saltar al campo civil. Palantir ya dio sus primeros pasos en este aspecto durante la pandemia, donde se ofreció por un precio simbólico como una tecnología de rastreo del Covid. A día de hoy, su uso se ha normalizado. Por ejemplo, en el Reino Unido Palantir ha llegado a un acuerdo con el gobierno conservador de Rishi Sunak para crear una plataforma que permita la interoperabilidad de datos entre los diferentes sistemas públicos y concertados de salud, algo que ya ha levantado las alarmas por los evidentes riesgos para la seguridad de datos de los pacientes.

No podemos caer en la trampa de la regulación, de la normalización de tecnologías destructivas. Hay cosas a las que sencillamente hay que decir que no. La única inteligencia artificial militar responsable, ética y segura es la que no existe.

Es toda una declaración de principios que el Ministerio de Defensa del gobierno más progresista de la historia confíe a una corporación racista, e involucrada con la extrema derecha internacional, el desarrollo de la inteligencia artificial con fines militares. Más aún cuando Palantir acaba de firmar un acuerdo con Israel para ofrecerle las garantías estratégicas que permitan seguir desplegando el apartheid en Palestina.

El gobierno español presume de que la IA es una herramienta para el progreso mientras confía la construcción de esta infraestructura militar a una corporación ultraderechista señalada por sus crímenes y violaciones de derechos humanos. ¿Cuál es esa ética de la que hablan los altos cargos del Gobierno de Pedro Sánchez?¿Y la responsabilidad? ¿Existe acaso alguna con el genocidio?¿Es la responsabilidad con políticas racistas, que brilla por su ausencia con la complicidad del Estado?¿La de los muros y las expulsiones?¿La de la vigilancia y el espionaje?

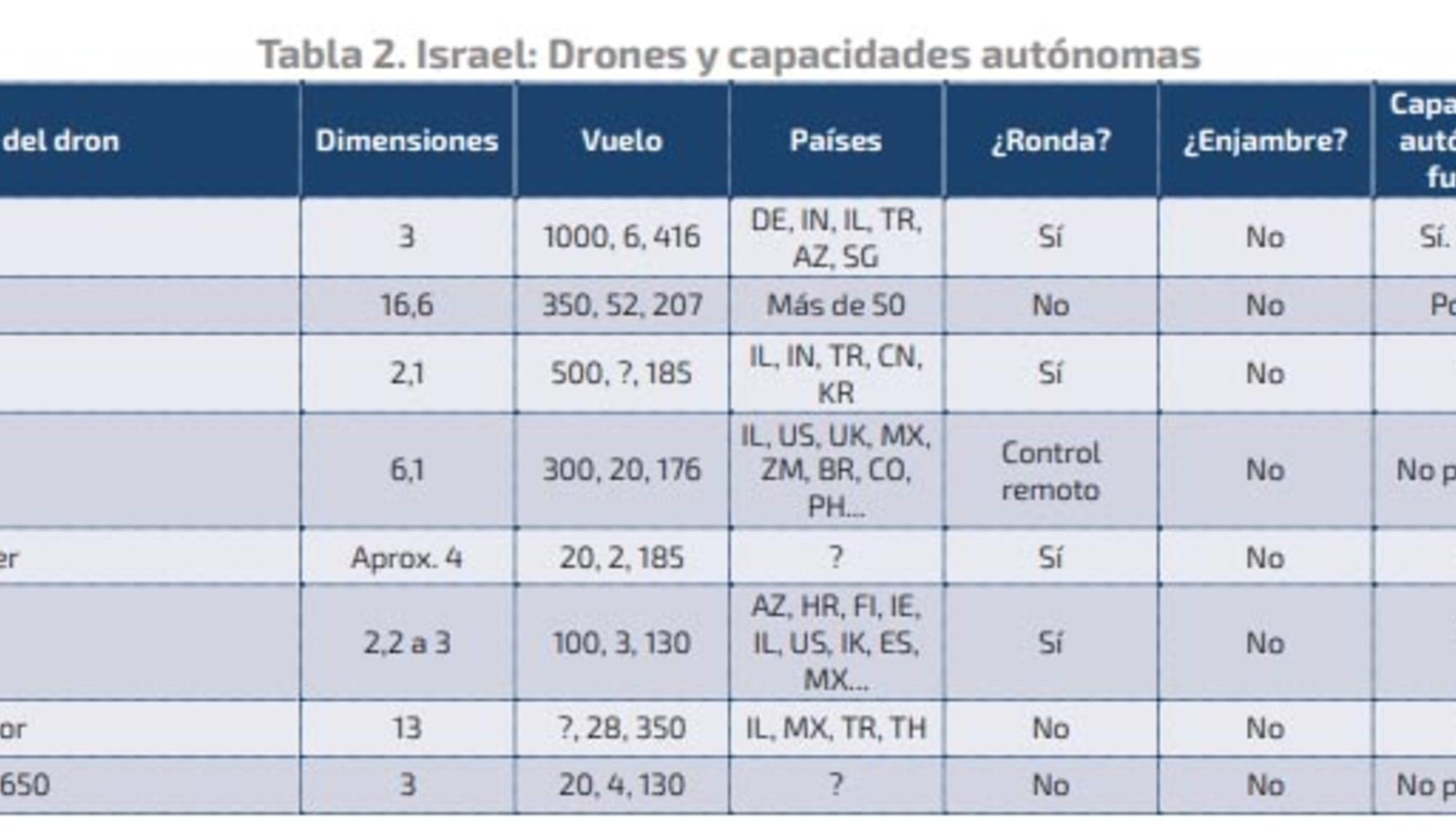

Los grandes lobbies armamentísticos, las grandes potencias tecnológicas y el mainstream académico nos dicen que la inteligencia artificial militar es inevitable y hasta necesaria, pero que es preciso regularla, esto es, asumirla como un hecho consumado, que podemos hacer de esta tecnología algo moral y responsable, que podemos diseñar armas democráticas ajustadas al derecho internacional humanitario, el mismo que humea entre los restos de los cadáveres de los asesinados basados en metadata. Hablan de inteligencia artificial ética mientras drones de la israelí Elbit Systems testados en Palestina patrullan el Mediterráneo a las órdenes de Frontex.

No podemos caer en la trampa de la regulación, de la normalización de tecnologías destructivas. Hay cosas a las que sencillamente hay que decir que no. La única inteligencia artificial militar responsable, ética y segura es la que no existe.

Capitalismo

Telefónica y el nuevo régimen del neoliberalismo militar

Ocupación israelí

El evangelio según Google

Espionaje

Los señores israelíes de la ciberguerra

Para comentar en este artículo tienes que estar registrado. Si ya tienes una cuenta, inicia sesión. Si todavía no la tienes, puedes crear una aquí en dos minutos sin coste ni números de cuenta.

Si eres socio/a puedes comentar sin moderación previa y valorar comentarios. El resto de comentarios son moderados y aprobados por la Redacción de El Salto. Para comentar sin moderación, ¡suscríbete!

.jpg?v=63939251485 2000w)

.jpg?v=63939251485 2000w)